Crise Post-Covid : comment mieux prévenir les impayés de ses abonnés ?

Dans un contexte de crise sanitaire ayant déjà fragilisé la santé économique de beaucoup d’entreprises, il est important que les équipes de management du risque et du recouvrement redoublent d’efforts afin que leurs clients paient en temps et en heure et n’entraînent ainsi pas de problématiques de trésorerie supplémentaires. Bien prédire, ou mieux prédire, ses futurs mauvais payeurs devient incontournable.

L’analyse de risque au carrefour de la multiplication des sources de données et des contraintes juridiques

Une chance : la volumétrie des données clients et prospects accessibles devient de plus en plus importante. Les gisements de données constituent désormais une opportunité permettant à la fois une connaissance approfondie des clients et prospects, mais en même temps une difficulté accrue pour les équipes d’analyser les risques et de proposer une méthode harmonisée de prévention et de gestion des impayés. Les actions possibles sont nombreuses et complexes à coordonner pour être ajustées à chaque niveau de risque client : orientation sur des moyens de paiement moins risqués, recours à des solutions de scoring de fraude selon le canal de vente, optimisation de la date de prélèvement, pratique d’une avance sur consommation avant la contractualisation, limitations provisoires de service, rééchelonnement des montants dus, accompagnement par le conseiller clientèle vers des niveaux de services plus adaptés à la situation de l’abonné, etc.

Une contrainte : le traitement des données personnelles est fortement encadré depuis le RGPD et notamment le droit d’accès et de rectification de ses données (et éventuelles mentions défavorables) figurant dans les fichiers clients des établissements financiers et autres organismes compilant les mauvais payeurs. Néanmoins, si le refus de vente à un consommateur demeure prohibé, la jurisprudence a toutefois fait entrer de longue date dans les « demandes anormales » le justifiant exceptionnellement, celles émanant de demandeurs à l’insolvabilité notoire.

Dès lors, la data science et le recours aux algorithmes de prédiction doivent permettre une analyse rapide et en temps réel d’une grande quantité d’informations pour proposer une aide à la décision objective et efficace à la vérification humaine des opérations à risque. À cette fin, Axys Consultants a eu la chance d’accompagner récemment un opérateur mobile sur ses démarches de scoring des nouveaux souscripteurs pour vous en proposer son retour d’expérience.

Afin de mener à bien cette mission, l’implémentation d’algorithmes de prédiction du niveau de risque pour un client à générer un impayé passe par un certain nombre d’étapes indispensables.

Définissez la problématique et l’indicateur métier que vous cherchez à prédire

Contrairement à l’acte de fraude qui est parfois ambigu et difficile à déceler, l’impayé est un acte immuable. La qualité d’un client, pour lequel un historique à être « bon payeur » ou « mauvais payeur » est disponible, peut donc être évaluée assez rapidement.

Ainsi, une approche supervisée sera privilégiée plutôt qu’une méthode non supervisée souvent moins performante. À savoir, un algorithme dont l’apprentissage se fera sur des données clients « étiquetées » ou « labelisées » (pour lesquelles l’étiquette « bon payeur » ou « mauvais payeur » est associée).

Différentes possibilités d’étiquetage existent et impliquent des méthodes de data science différentes : classer les clients en 2 catégories « bon » et « mauvais payeur » (problème de classification binaire), en plusieurs catégories en introduisant une gradation de la gravité du caractère « mauvais payeur » (classification multi-classes) ou enfin prédire directement un risque d’être mauvais payeur (régression). L’expérience montre qu’il est souvent plus simple de classifier les clients en catégories plutôt que d’essayer de prédire directement une variable continue (régression). Dans un premier temps, une méthode de classification binaire sera donc privilégiée.

Toute l’approche repose donc sur cette notion de « mauvais payeur », qu’il est essentiel de définir précisément d’un point de vue métier au préalable : dans quels cas un abonné sera considéré « bon payeur » et dans quels cas il sera considéré « mauvais payeur ». Voici par exemple quelques questions qu’il sera judicieux de se poser :

- A partir de quelle ancienneté un client qui n’a jamais généré d’impayé peut-il être considéré comme « bon payeur » ?

- Ou doit-on attendre qu’un client soit résilié sans avoir fait défaut pour lui donner l’étiquette de « bon payeur » ?

- A l’inverse, est-ce que toute personne ayant au moins généré un impayé au cours de sa vie doit être considéré comme « mauvais payeur » ?

- Y a-t-il des cas à exclure ? Comme par exemple certains codes de rejet de prélèvements SEPA liés à des erreurs techniques ?

Les réponses à ces questions permettront de définir précisément l’échantillon de données clients étiquetées servant d’entraînement à l’algorithme d’apprentissage. Il est important de noter qu’il n’y a pas de réponse générale à ces questions et qu’elles dépendent beaucoup de votre métier ou secteur.

Enfin, pour délimiter complétement la base de données d’apprentissage, il faut déterminer l’historique nécessaire de données étiquetées. Cette fenêtre de temps nécessaire dépendra du volume de nouveaux abonnés mensuels de votre entreprise, et sera fonction de la capacité à mettre à disposition ces données étiquetées. Il va de soi que l’apprentissage du modèle prédictif sera d’autant meilleur que la base de cas de « bon payeur » et « mauvais payeur » sera étayée. Il est également intéressant d’avoir un historique suffisamment long pouvant faire apparaître des effets de cycles ou saisonnalité. Pour ces raisons, nous avons donc choisi de nous baser sur un historique de deux ans de données clients pour notre approche de scoring avec l’opérateur téléphonique.

Explorez vos données et sélectionnez les plus pertinentes : pas de fumée sans feu !

Les data scientists ne sont pas des magiciens. Prédire justement le caractère « mauvais payeur » suppose d’avoir les données les plus pertinentes possibles. La préparation des données, ou feature engineering, est un travail de longue haleine pour les data scientists, souvent malheureusement négligé. Les résultats dépendent en effet directement de la capacité du data scientist à extraire les bonnes « features ».

Voici par exemple quelques types de données qu’il sera intéressant d’intégrer selon le cas pour avoir une vision à 360° de vos abonnés :

- Données sociodémographiques : âge, sexe, nationalité, langue, situation civile et familiale, CSP, lieu de vie, etc.

- Données comportementales liées aux goûts, choix et habitudes de consommation : historique des produits achetés ou services souscrits, options souscrites, fréquence d’achat et niveau d’utilisation des services, canal de souscription, etc.

- Données financières : banque, choix du mode de paiement, jour de prélèvement, etc.

- Données externes et enrichissement via des open datas:

1. Données macro-économiques territoriales

L’INSEE publie tous les trois ou quatre ans un certain nombre d’indicateurs (éducation, chômage, revenus, démographie) à l’échelle de l’IRIS par exemple. Les Îlots Regroupés pour l’Information Statistique sont une maille élémentaire infra-communale de découpage du territoire français qui correspondent à des sortes de quartiers d’environ 2 000 habitants.

2. Données épidémiologiques

La conjoncture sanitaire actuelle nous force à changer notre paradigme et notre façon de penser afin d’intégrer le risque de crise sanitaire dans la prise de décision. La souscription d’un service ou sa mise en œuvre peut être fortement impactée selon le département. Il est aussi nécessaire de prendre en compte leur impact pour actualiser le modèle, notamment celui sur les effets liés aux séries temporelles.

Une fois que toutes les variables jugées pertinentes par la prédiction ont été définies, il peut être judicieux d’utiliser des méthodes de réduction de dimensions ou de sélection de variables afin de ne sélectionner que les variables qui sont réellement les plus pertinentes statistiquement parlant. Ceci est particulièrement important lorsque la volumétrie de variables est importante, en particulier les variables qualitatives dont l’encodage nécessaire à l’application de méthodes de machine learning fera exploser le nombre de variables finales.

Les méthodes de réduction dimensionnelle de type PCA (Principal Component Analysis ou ACP pour Analyse en Composantes Principales en français) sont très pratiques mais créent des combinaisons linéaires des variables existantes qu’il est parfois difficile d’interpréter.

C’est pourquoi, pour une meilleure interprétabilité des résultats, il est utile de privilégier une méthode de sélection de variables : tests statistiques (ANOVA, Chi2, t-test de Student…), suppression de variables colinéaires, Forward selection, Backward elimination, etc.

Tout un travail de nettoyage de données doit ensuite être effectué afin que l’algorithme de machine learning apprenne sur des données complètes et saines. Pour chaque variable, l’information est parfois stockée dans plusieurs sources de données avec des niveaux de complétude différents. Afin de faciliter la construction du dataset et de rendre industriels tous ces retraitements, nous ne pouvons que recommander l’utilisation d’un outil d’agrégation, normalisation et nettoyage de la donnée. L’outil Alteryx que nous avons par exemple utilisé lors de la mission de scoring pour l’opérateur téléphonique nous a permis de mettre en place un workflow de transformation des données, assurant un gain de temps conséquent dans la préparation des données ainsi que plus de transparence.

Choix de l’approche pour l’apprentissage automatique

De nombreuses méthodes de machine learning ont été développées au cours des dernières années. Chaque méthode ou ensemble de méthodes possède ses spécificités et ses cas d’usage. Il est donc recommandé de faire une présélection des méthodes adaptées au problème posé puis de les mettre ensuite en compétition.

Des éléments importants à prendre en compte sont par exemple la nature des données (plutôt quantitatives ou qualitatives), la volumétrie de données de la base d’apprentissage, le caractère linéaire ou non du phénomène que l’on cherche à prédire ou l’explicabilité du modèle.

Pour une bonne explicabilité du modèle, il vaut mieux privilégier par exemple des méthodes ensemblistes qui permettent d’extraire l’importance de chaque variable dans la prédiction finale (Random Forest, Boosting) et donnent de très bons résultats ou une méthode linéaire (comme SVM pour Support Vector Machine). Pour ces derniers, les coefficients de la régression autorisent l’observation directe de la contribution de chaque variable dans la prédiction.

Les méthodes à noyaux et surtout les réseaux de neurones, de plus en plus à la mode, peuvent donner des résultats remarquables et modéliser des phénomènes très complexes lorsqu’une volumétrie de données conséquentes est à disposition. Mais ces méthodes sont souvent considérées comme des « boîtes noires ».

Lors de notre mission de scoring de risque d’être « mauvais payeur », nous avons opté pour des méthodes ensemblistes et testé des algorithmes de Random Forest et XGBoost. C’est finalement le Random Forest qui a été retenu.

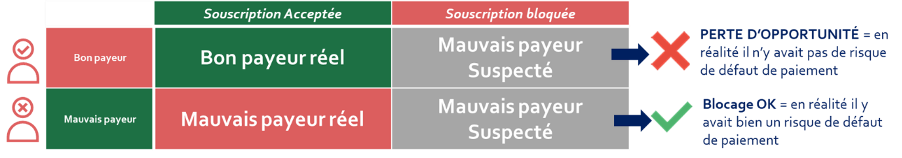

Une fois l’entraînement du modèle réalisé, les résultats de l’algorithme peuvent (et doivent !) être déterminés avec une fonction d’évaluation (aussi appelée score ou métrique de performance). Elle permet ainsi d’évaluer le niveau de confiance dans les prédictions retournées par l’algorithme. Dans le cas d’une classification binaire (« bon payeur » / « mauvais payeur »), chaque prédiction peut être classée dans une matrice de confusion (True Positive / False Positive et False Negative / True Negative) comme ci-dessous :

Il est important de noter que les deux types d’erreurs du tableau ci-dessus n’ont pas forcément le même impact. Celui-ci dépend bien-sûr du type de secteur ou service vendu et du montant en jeu pour l’analyse de risque. Pour un opérateur téléphonique par exemple, l’impact financier de bloquer un client bon payeur de ses abonnements mensuels récurrents est par exemple souvent plus fort que celui d’accepter un client qui s’avérera être un mauvais payeur avant sa résiliation. Mais ce sera en revanche l’inverse pour une banque concernant un accord de crédit, dont la somme du prêt potentiellement en défaut de remboursement est autrement plus élevée.

Le choix de la méthode d’évaluation est donc une étape cruciale, les limites du modèle se traduisant immédiatement en risque financier. En repartant de la matrice de confusion, différentes méthodes de scoring existent dont en voici quelques exemples couramment utilisés :

- Accuracy : (TP+TN)/(TP+TN+FP+FN)

C’est le taux de prédictions correctes sur l’ensemble des prédictions.

- Rappel (Recall) ou Sensibilité : TP/(TP+FN)

C’est l’ensemble des mauvais payeurs prédits à raison divisé par l’ensemble des mauvais payeurs réels. On cherche ici à minimiser le taux de FN, à savoir le taux de mauvais payeurs prédits bons payeurs.

- Précision : TP/(TP+FP)

C’est l’ensemble des mauvais payeurs prédits à raison divisé par l’ensemble des mauvais payeurs prédits. On cherche ici à minimiser le taux de FP, à savoir le taux de bons payeurs prédits mauvais payeurs.

- F-mesure : C’est la moyenne harmonique des 2 précédents scores.

- Courbe ROC (Receiver Operating Characteristic) et AUC (Area Under the Curve) : Basées sur la courbe ROC, à savoir la courbe Sensibilité / Spécificité, ces méthodes permettent d’évaluer les performances du classifieur lorsque le seuil de discrimination varie, seuil permettant de déterminer si un client est « bon payeur » ou « mauvais payeur ». Cette méthode pourra être utilisée afin de pouvoir moduler à l’avenir ce seuil tout en gardant de bons résultats.

Par ailleurs, l’un des fardeaux du data scientist est le « surapprentissage ». Il apparaît lorsque qu’un algorithme d’apprentissage donne de très bons résultats sur les données d’apprentissage, en capturant très bien les subtilités de ce jeu de données, mais généralise très mal le problème à de nouvelles données. Il conviendra donc d’appliquer les méthodes classiques de data science : découpage du jeu de données en parties pour test et entraînement, cross-validation des résultats, sélection des paramètres du modèle avec une méthode Grid.

Selon les produits ou services vendus et le type de clientèle, le ratio « bon payeur » / « mauvais payeur » peut être très différent. Si ce ratio est très déséquilibré, comme par exemple 10 « bon payeurs » pour 1 « mauvais payeur », l’utilisation de techniques liées au caractère déséquilibré du jeu de données (unbalanced dataset) permettra d’améliorer les résultats. Le risque est en effet dans ce cas que l’algorithme fasse une prédiction évidente qui consiste à taguer tous les clients comme « bon payeur », tout en ayant de très bons résultats (par exemple un taux accuracy de 90 % dans le cas d’un rapport de 1/10). Parmi les méthodes classiques pour pallier ce problème, on peut citer : la collecte de plus de données, le changement de fonction d’évaluation (l’accuracy n’étant par exemple pas la bonne méthode d’évaluation comme démontré plus haut), faire du sur-échantillonnage ou du sous-échantillonnage, utiliser des modèles de classification pénalisée (penalized classification), etc.

Il est important de constater qu’il peut exister un biais de sélection dans l’échantillon de population entre la population cliente existante (permettant l’entraînement du modèle) et la population de souscripteurs à évaluer. En effet, les données d’entraînement « étiquetées » ne peuvent être basées que sur les données de clients contractualisés et non sur des souscripteurs en cours n’ayant jamais finalement contractualisé. Par définition, impossible de savoir si une souscription bloquée n’ayant jamais pu aboutir à un premier paiement correspondait à un bon ou mauvais payeur.

Or, votre équipe risque fait sûrement déjà un travail d’analyse et de contre-mesures (telles que des demandes d’avances sur consommation ou des limitations provisoires de service) basé sur des critères bien déterminés. Ceci a pour effet de bloquer un certain nombre de souscriptions qui correspondent à ces critères de risque. La population cliente finale est donc biaisée et les facteurs de risques actuels sont sous-représentés. Il existe des techniques dites de « débiaisage » afin de pallier ce problème dont les principales sont :

- Reclassification itérative: elle consiste à entraîner dans un premier temps le modèle sur les bons et mauvais payeurs réels, puis à prédire le reste de la population (les suspectés). Une étiquette est ainsi assignée à l’ensemble de la population (souscriptions acceptées et bloquées). Le modèle est alors réentraîné sur cette population élargie et les mauvais payeurs suspectés font l’objet d’une prédiction. L’algorithme s’arrête lorsque les étiquettes de la population de mauvais payeurs suspectés se stabilise d’une itération à l’autre.

- Groupe de contrôle: Il s’agit de prendre un échantillon de population pour lequel aucun contrôle n’est réalisé, permettant ainsi pour cette population de s’affranchir du biais. L’entraînement de l’algorithme se fait alors sur cet échantillon. Attention, cette méthode coûte chère avec des pertes immédiates liées à l’acceptation de « mauvais payeurs » pour pouvoir constituer l’échantillon. Un arbitrage gain estimé par l’amélioration de l’algorithme d’analyse de risque vs perte financière immédiate est à réaliser.

Enrichissez, testez et réentraînez !

Une fois tous ces éléments pris en compte, l’entraînement du modèle prédictif est une approche itérative qu’il faut imaginer dans des cycles d’amélioration continue avec boucles d’enrichissement de données et réentraînement du modèle. L’ajustement des workflows métiers qui en découle est aussi l’occasion d’affiner les prédictions.

En résumé, la mise en place d’un modèle de machine learning pour la détection de risque d’impayé vous permettra d’automatiser et de systématiser l’analyse de risque, de diminuer la subjectivité des critères entre les conseillers effectuant l’évaluation et d’augmenter l’homogénéité dans le temps de votre score. Il vise ainsi à vous donner les moyens d’allouer le bon niveau d’effort et de ressources au niveau de risque estimé.

Dans notre cas, par la prise en compte d’un beaucoup plus grand nombre de paramètres, cette méthode a permis pour l’opérateur téléphonique d’améliorer grandement les taux de rappel et précision du modèle de scoring (un rapport d’un à trois entre la méthode « semi-manuelle » et la méthode « machine learning » sur le taux de rappel notamment).

Dernier conseil : lors de l’implémentation des règles métiers déclenchant les contre-mesures retenues pour prévenir le risque d’impayé (génération adaptée du montant de l’avance sur consommation, limitation provisoire de services ou blocage des souscriptions les plus risquées), ne partez jamais sur une automatisation aveugle. Pensez à retenir cette logique de test & learn pour surveiller l’impact sur vos taux d’impayés et vos volumes de souscripteurs bloqués. Le score doit venir accompagner la connaissance et l’analyse éclairée des équipes métier.